De opiniesite van BNNVARA met actueel nieuws en uitgesproken meningen.

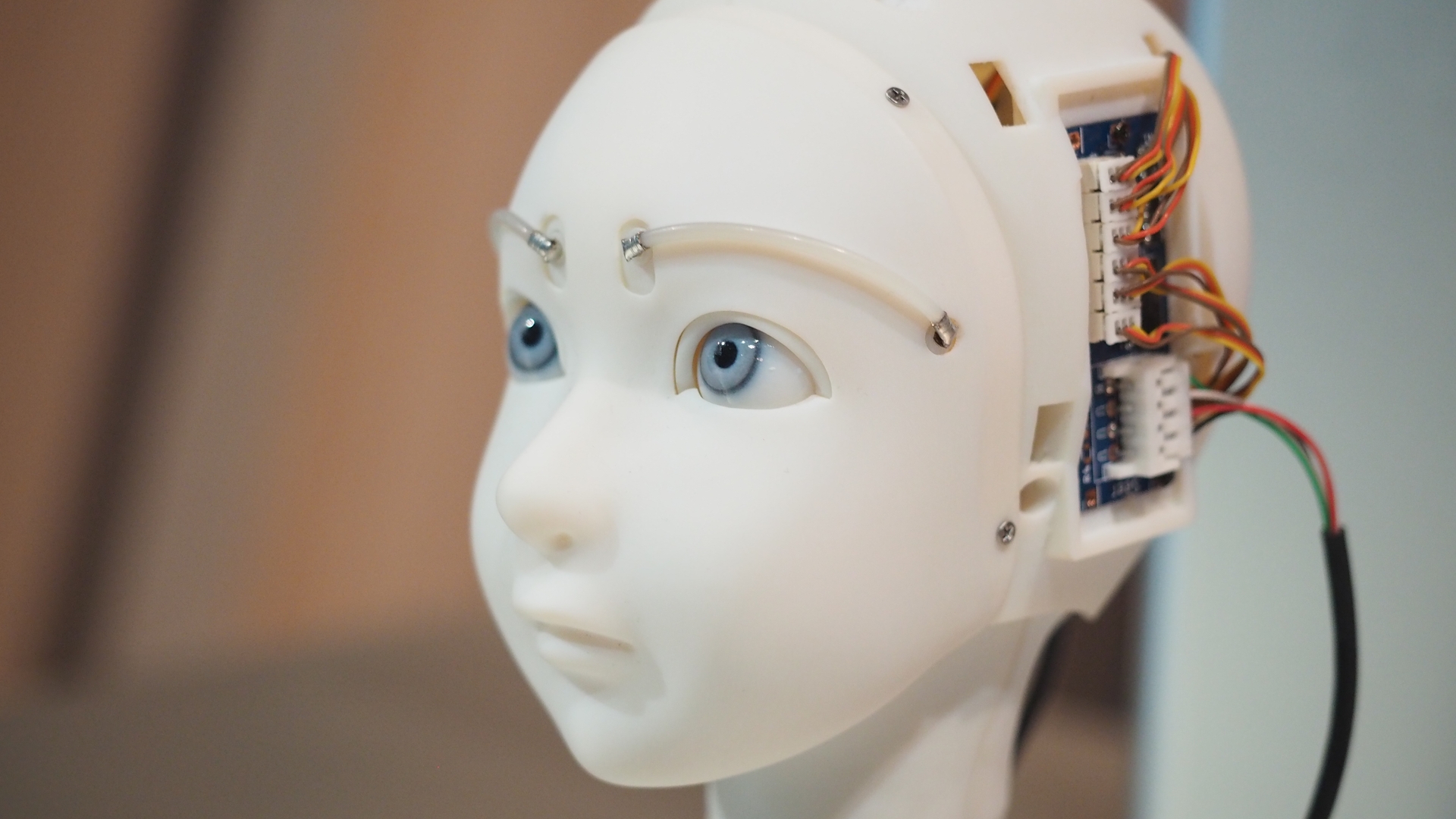

Kunstmatig racisme

© cc-foto: Ars Electronica / Martin Hieslmair

Terwijl het besef dat algoritmes niet heilig zijn overal begint door te dringen, gaan wij ze op een zeer gevaarlijke manier gebruiken.

‘Hey Google, speel Roar van Katy Perry.’ Onze dochter van vier weet zich uitstekend te vermaken met het speeltje dat we in huis hebben gehaald: Google Home. Een slimme assistent die ons leven makkelijker zou moeten maken. Google doet op commando het slimme licht in ons huis van Philips Hue aan of uit, vertelt me ’s ochtends wanneer ik gehaast mijn schoenen aantrek om de deur uit te sprinten wat het weer wordt en hoe druk het op de weg is, houdt een boodschappenlijstje bij, somt het laatste en belangrijkste nieuws op en speelt dus op commando liedjes van Spotify af.

En dit is pas het begin. Google Home staat nog in de kinderschoenen, maar op den duur verwacht ik dat ze – ja de assistent is, hoe cliché, een vrouw – echt onderdeel van het gezin zou kunnen worden, zoals onze poes Lola dat ook is. Zij het met meer competenties dan krabben en purren.

Dankzij de data waar wij en andere Google Home-gebruikers haar mee voeden, leert ze steeds meer. Uiteindelijk verwacht ik dat zij dankzij haar kunstmatige intelligentie ook zelfstandig zal kunnen denken en handelen, zonder verdere tussenkomst van menselijke actie. Ongeacht hoe je tegen technologische vooruitgang kijkt, klinkt dat best eng. Het is maar te hopen dat een apparaat dat zelf kan beslissen, het juiste besluit. En wie bepaalt dan wat het juiste is?

Grote techbedrijven als Google, Amazon en Apple krijgen dankzij de apparaten bovendien nog meer van onze data in handen, zonder dat wij zicht hebben op wat ze ermee doen. We geven hen met onze data inzicht in onze gewoonten en gebruiken, in onze angsten en onze dromen. Het is een eitje om hierop in te spelen, of erger nog: ons te manipuleren. Scenario’s uit de fictieve televisieserie Black Mirror blijken plots lang niet zo hypothetisch.

En dan zijn er nog de privacyschendingen. Neem nu Echo, de Google Home-equivalent van Amazon. Vorig jaar mei werd nog bekend dat Echo een gesprek dat een gezin in de nabijheid van het apparaat voerde in zijn geheel heeft opgenomen, en naar iemand in hun contactlijst heeft verstuurd. ‘Een foutje in het interpreteren van woorden uit het gesprek’, laat Amazon in een reactie weten. Feit blijft echter wel dat Echo de hele tijd met het gezin meeluisterde en dat Google dat bij ons thuis nu ook doet.

Toch heb ik besloten haar in huis te halen, met alle mogelijke gevolgen van dien. Niet alleen omdat het zo’n gave gadget is, maar omdat ik ervan overtuigd ben dat dit de toekomst is en ik liever nu al de werking en gevaren ervan leer begrijpen, dan later.

Inmiddels is mijn conclusie dat privacyschendingen door Google Home nog de minst van mijn zorgen zijn. De aanname dat kunstmatige intelligentie ‘neutraal’ en ‘onbevooroordeeld’ zou zijn, omdat het gebaseerd is op objectieve data – énen en nullen – is volgens mij een nog veel groter probleem.

De programmeur heeft namelijk een flinke vinger in de pap. Met zijn algoritme kan hij (of zij, maar programmeurs zijn vaker man dan vrouw) de bots en robots sturen. Dat kan hij bewust doen. Google Home geeft bijvoorbeeld geen antwoord op de vraag wie Jezus Christus was, maar antwoordt: “Het geloof kan ingewikkeld zijn, ik ben er nog steeds over aan het leren.” Volgens een woordvoerder geeft de Google-assistent hier geen informatie over omdat bepaalde onderwerpen ‘kwetsbaarder zijn voor vandalisme en spam’. Het antwoord komt van het web en kan door gebruikers gemanipuleerd worden en Google wil dat – terecht – voorkomen.

Het verklaart echter niet waarom de assistent lange tijd wél antwoord gaf op vragen over de islamitische profeet Mohammed, Krishna, Boeddha en andere religieuze figuren. Pas na kritiek op het ontbreken van informatie over Jezus Christus werden ook deze zoekresultaten “geneutraliseerd”. Google bepaalt dus bewust wat de assistent wel en wat ze niet met ons mag delen.

In een interview met Vrij Nederland zegt Rachel Botsman, docent aan Oxford University en auteur van het boek Who Can You Trust? , dat omgaan met kunstmatige intelligentie van bots en robots in de toekomst de belangrijkste uitdaging zal zijn. In haar ervaring hebben jongeren nu al betere vragen over kunstmatige intelligentie. Botsman:

"‘Ze proberen de intenties van de machine te begrijpen. Ik vraag ze dan: op grond waarvan zou je Alexa eigenlijk vertrouwen? En Amazon? Uiteindelijk moet je voor verantwoording achter de algoritmes op zoek naar degene die de code schrijft, die de machine programmeert – en welke belangen diegene dient.’"

Naast eventuele belangen speelt echter ook wat ik noem “de menselijke factor” een grote rol, wanneer onbewuste vooroordelen in algoritmes terechtkomen.

Onze vooroordelen, onze normen en waarden, hoe wij over elkaar denken en hoe wij ons – als maatschappij – in Nederland, maar ook ver daarbuiten, tot elkaar verhouden, vormt de basis van kunstmatige intelligentie. En die basis is niet zo neutraal als hij soms lijkt. Wanneer een apparaat, een mechanisme of een systeem dat door mensenhanden is gemaakt, als neutraal wordt ervaren, terwijl het eigenlijk vooroordelen in zich geprogrammeerd heeft, kunnen de gevolgen desastreus zijn. Het is niet voldoende om te weten dat de vooroordelen bestaan, bij alles wat we doen moeten we er van doordrongen zijn.

Zelfs bij de grote techbedrijven gaat dat lang niet altijd goed. In oktober vorig jaar kondigde Amazon aan te zullen stoppen met de geautomatiseerde afhandeling van sollicitaties. Het bedrijf maakte gebruik van AI in de sollicitatieprocedure, maar moest nu tot de conclusie komen dat de procedure niet neutraal is maar bepaalde mensen – mannen – voor technische functies bevoordeelt. Doordat de tool gevoed is met data van eerdere werknemers – voornamelijk mannen – was het systeem in de basis al geneigd om eerder mannen aan te nemen dan vrouwen, zelfs wanneer de vrouwen meer gekwalificeerd waren.

Of wat dacht je van het rechterlijk systeem in de Verenigde Staten? Honderden rechtbanken laten daar een programma voorspellen of een veroordeelde mogelijk nog eens de fout in zal gaan. ProPublica , een gerenommeerd nonprofit nieuwsorganisatie, onderzocht het systeem en kwam tot de conclusie dat het zwarte Amerikanen enorm benadeelt. Het systeem – Correctional Offender Management Profiling for Alternative Sanctions (COMPAS ) – wijst zwarte mensen vaker onterecht aan als recidivisten; in maar liefst 45 procent van de gevallen zat het systeem er bij zwarte verdachten naast, bij witte mensen slechts 24 procent.

An sich is dat al heel vervelend en racistisch, maar rechters kunnen ook nog eens de hoogte van de borg of de lengte of zwaarte van een straf baseren op de uitkomst van het programma. Wie volgens het systeem mogelijk nog eens de fout in zal gaan, moet langer zitten. De rechter is zich van geen kwaad bewust, want programma’s – zo denkt men vaak nog steeds – zijn immers neutraal.

In Nederland lopen we zoals gewoonlijk hopeloos achter op de technologische ontwikkelingen. Terwijl het besef dat algoritmes niet heilig zijn overal begint door te dringen, gaan wij ze op zeer gevaarlijke manier gebruiken. Met behulp van het Systeem Risico Indicatie (SyRI) van het ministerie van Sociale Zaken en Werkgelegenheid bijvoorbeeld. In Nederland worden du moment hele wijken doorgelicht op basis van algoritmes om ‘potentiële fraudeurs’ op te sporen. De algoritmes worden gevuld met allerhande data: van schuldenlastgegevens tot inburgeringsgegevens, van onderwijsgegevens tot je zorgverzekeringsgegevens.

Inmiddels heeft de Rotterdamse gemeente aangekondigd de gegevens te zullen gebruiken om 1200 huisbezoeken af te leggen met een zogenaamd ‘sociaal interventieteam’. Niet overal in Rotterdam, nee, alleen in ‘krachtwijken’ als Hillesluis en Bloemhof. Wijken waar de inwoners het doorgaans minder breed hebben en veelal afhankelijk zijn van sociale voorzieningen als een (bijstands-)uitkering en belastingtoeslagen.

De algoritmes beoordeelden deze inwoners, in de wijken waar de inwoners overigens overwegend een migratieachtergrond hebben, als ‘een verhoogde kans op fraude’. Nog voordat er iets bewezen is – je weet wel, de onschuldpresumptie – geeft de overheid zichzelf het recht de privacy van al deze inwoners massaal te schenden, omdat een algoritme vermoedt dat iemand naast zijn of haar bijstandsuitkering zo nu en dan wat bijverdient door het huis van een kennis schoon te poetsen, want dat zijn de grote problemen van Rotterdam.

Ronald Huissen van het Platform Bescherming Burgerrechten noemde SyRI eerder in NRC een onderbelicht project:

"“We hebben een uitgebreide verzorgingsstaat en deze krijgt met dit systeem een repressief karakter,” zegt hij. “Allerlei gegevens kunnen tegen je worden gebruikt. Je kan zonder dat te weten op een risicolijst worden geplaatst. Het is een groot, schimmig en oncontroleerbaar systeem.”"

“Makkelijke doelwitten dus, al vormt uitkeringsfraude maar een fractie van wat er in Nederland breed gefraudeerd wordt,” schrijft NRC-columnist Lotfi El Hamidi terecht, terwijl hij zich af vraagt wat er zou gebeuren als het systeem niet op de bewoners van Rotterdam-Zuid maar op die van Amsterdam-Zuid worden toegepast.

De hoop was lange tijd dat steeds meer bedrijven, organisaties en gebruikers bewust worden van de ethische vraagstukken en vooroordelen van AI en dat alle energie wordt gestoken in het elimineren van deze bias. “De realiteit is dat kunstmatige intelligentie en machine learning en algoritmes in het algemeen door niemand anders dan door ons – mensen – zijn ontworpen”, aldus Dipayan Ghosh, fellow aan Harvard in The New York Times. “AI neemt de data als input en trekt er met de snelheid van het licht conclusies uit over de wereld.” Volgens Ghosh is het noodzakelijk om geld, tijd en energie te investeren in het uitroeien van de vooroordelen in de algoritmes, om te voorkomen dat de conclusies fouten bevatten die wij als samenleving niet herkennen als zodanig.

Maar wat nu als een overheid precies aan dat gegeven geen boodschap heeft?

Praat mee

Altijd op de hoogte blijven van het laatste nieuws?

Meld je hieronder gratis aan voor Joop NL. Iedere donderdag een selectie opvallende nieuwsverhalen, opinies en cartoons in je mailbox.